GLM-Z1 系列模型已下线,建议选择最新旗舰文本模型 GLM-4.6,该模型同样支持思考模式。

概览

GLM-Z1 系列包含Air、AirX、FlashX、Flash这四个模型。

- GLM-Z1-Air 是一款具备深度思考能力的推理模型。该模型通过推理数据增强和对齐优化,数理推理能力显著增强,适合高频调用场景。GLM-Z1-AirX 为该模型的高速版。

- GLM-Z1-FlashX 具有超快推理速度和更快并发保障,极致性价比,进一步降低推理模型的使用门槛,是免费推理模型 GLM-Z1-Flash 的增强版本。

- GLM-Z1-Air

- GLM-Z1-AirX

- GLM-Z1-FlashX

- GLM-Z1-Flash

定位

高性价比

价格

0.5 元 / 百万 Tokens

输入模态

文本

输出模态

文本

上下文窗口

128K

最大输出 Tokens

32K

能力支持

内置深度思考

默认内置深度思考,提供更深层次的推理分析

流式输出

支持实时流式响应,提升用户交互体验

Function Call

强大的工具调用能力,支持多种外部工具集成

上下文缓存

智能缓存机制,优化长对话性能

结构化输出

支持 JSON 等结构化格式输出,便于系统集成

MCP

可灵活调用外部 MCP 工具与数据源,扩展应用场景

推荐场景

人岗匹配

人岗匹配

快速、精准地提取简历中的技能与岗位要求,结合专业度、技能、经验等维度生成量化匹配度报告,为企业招聘提供科学依据。

剧本创作

剧本创作

生成完整剧本内容,覆盖角色对白、场景转换与情节冲突设计等多类型创作需求,支持连续剧集剧情结构与情感的衔接。(推荐与搜索工具结合,获取热点、流行趋势、社会关注,让剧本紧跟潮流)

文献对比分析

文献对比分析

自动化解析海量文献的核心观点与数据,精准识别跨文献的研究方法异同及结论关联性,输出结构化对比结论与分析报告。

小语种数据合成

小语种数据合成

支持用户通过少量的优质小语种种子数据,利用数据合成功能合成大量的类似数据,使得合成的小语种语料不高度相似且不掺杂其他信息。

使用资源

体验中心:快速测试模型在业务场景上的效果接口文档:API 调用方式

详细介绍

GLM-Z1-Air

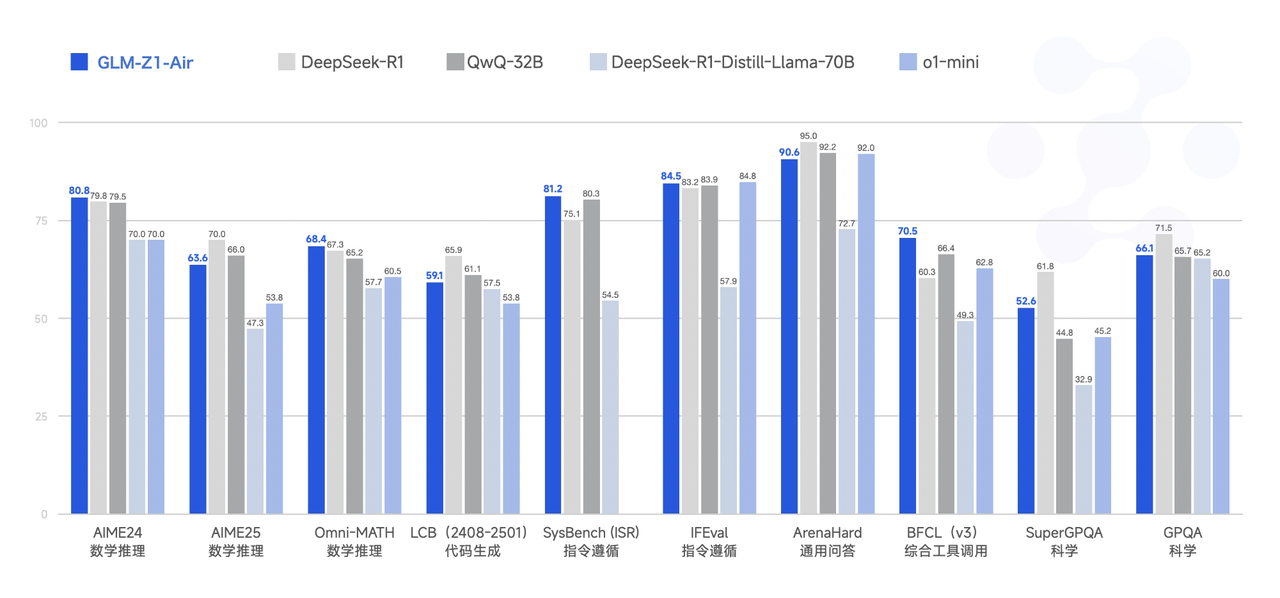

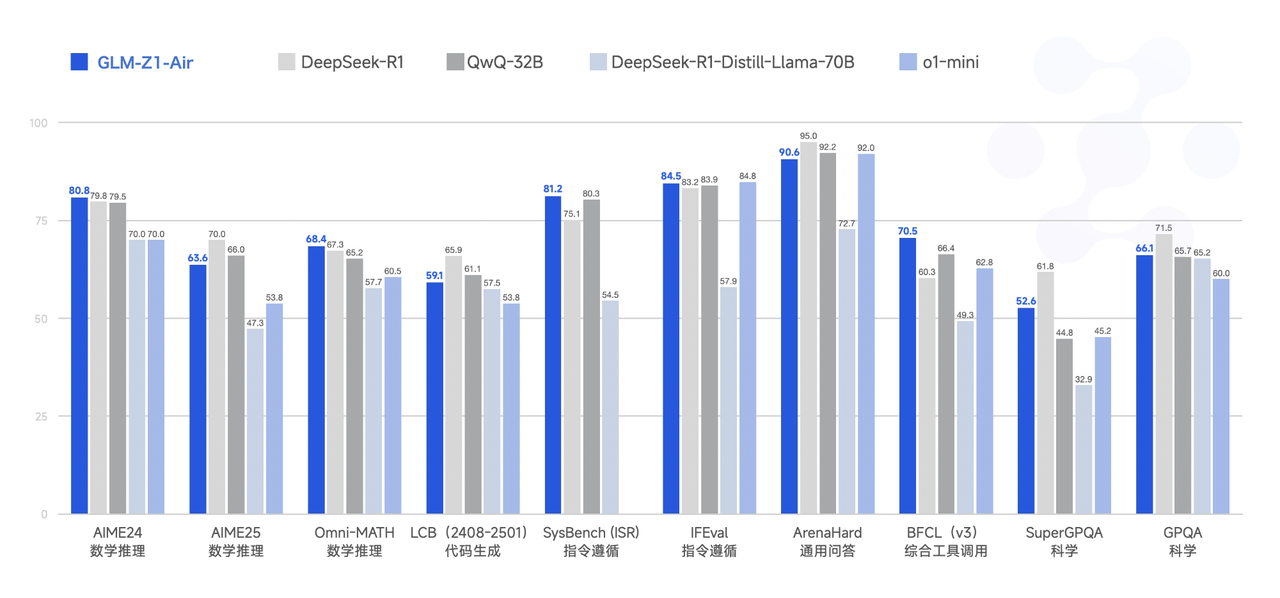

GLM-Z1-Air 在 GLM-4-Air-250414 的基础上,采用了冷启动与扩展强化学习策略,并针对数学、代码、逻辑等关键任务进行了深度优化训练。与基础模型相比,GLM-Z1-Air 的数理能力和复杂问题解决能力得到显著增强。此外,训练中整合了基于对战排序反馈的通用强化学习技术,有效提升了模型的通用能力。在部分任务上,GLM-Z1-Air 通过在 AIME 24/25、LiveCodeBench、GPQA 等基准测试中的评估,展现了较强的数理推理能力,能够支持解决更广泛复杂任务。

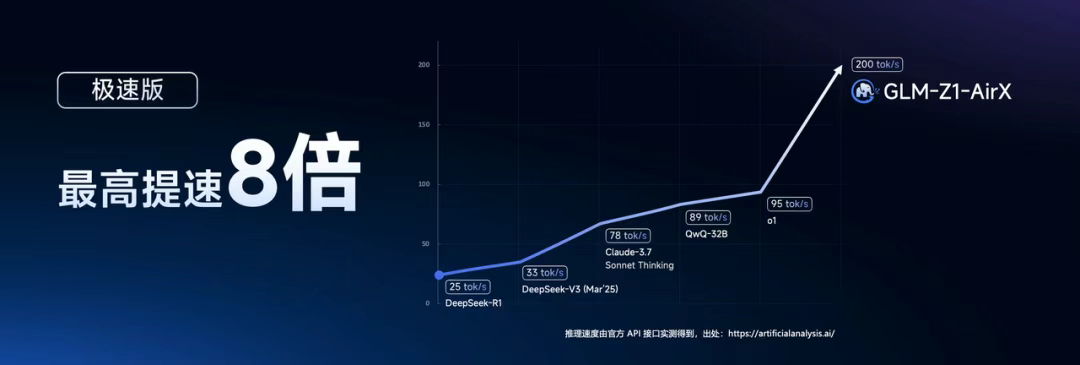

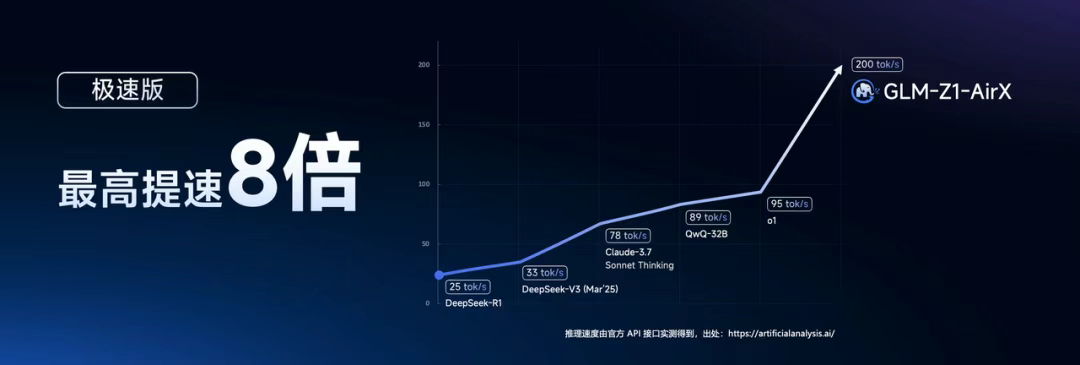

GLM-Z1-AirX

GLM-Z1-AirX 在训练中整合了基于对战排序反馈的通用强化学习技术,有效提升了模型的通用能力。该模型具备强大的复杂推理能力,在逻辑推理、数学、编程等领域表现优异,推理速度极快远超同类模型。GLM-Z1-AirX 专为高频调用场景设计,在实时数据分析、智能客服等高并发业务中,可实时响应显著降低用户等待耗时。

GLM-Z1-FlashX

GLM-Z1-FlashX 作为轻量化解决方案,在保留 GLM-Z1-Air 完整技术栈的前提下,更轻量级、更高速、更优惠。虽然参数量更少,但 GLM-Z1-FlashX 在数学逻辑推理、长文档处理、代码生成等复杂任务中依然表现出色,整体性能已达到同尺寸开源模型的主流水准。 GLM-Z1-FlashX 为开发者提供低门槛 AI 实验与轻量化部署支持,兼顾推理效率与推理成本,尤其适合高频调用场景。

调用示例

以下是一个完整的调用示例,以 GLM-Z1-Air 模型为例。

- cURL

- Python

- Java

- Python(旧)

基础调用流式调用

用户并发权益

API 调用会受到速率限制,当前我们限制的维度是请求并发数量(在途请求任务数量)。不同等级的用户并发保障如下。

- GLM-Z1-Air

- GLM-Z1-AirX

- GLM-Z1-FlashX

- GLM-Z1-Flash

| V0 | V1 | V2 | V3 |

|---|---|---|---|

| 30 | 40 | 50 | 60 |