GLM-4.1V-Thinking 系列是 10B 尺寸性能卓越的视觉推理模型。它在图表/视频理解、前端 Coding、GUI 任务等核心能力达到全面新 SOTA,并引入思维链推理机制,显著提升模型在复杂场景中的回答精准度与可解释性。

GLM-4.1V-Thinking-FlashX

GLM-4.1V-Thinking-Flash

内置深度思考 默认内置深度思考,提供更深层次的推理分析

精准识别并综合分析图像与文本信息。

支持持复杂题解、多步演绎与公式理解。

具备时序分析与事件逻辑建模能力。

理解界面结构,辅助自动化操作。

语言与图像区域精准对齐,提升人机交互可控性。

体验中心 :快速测试模型在业务场景上的效果接口文档 :API 调用方式

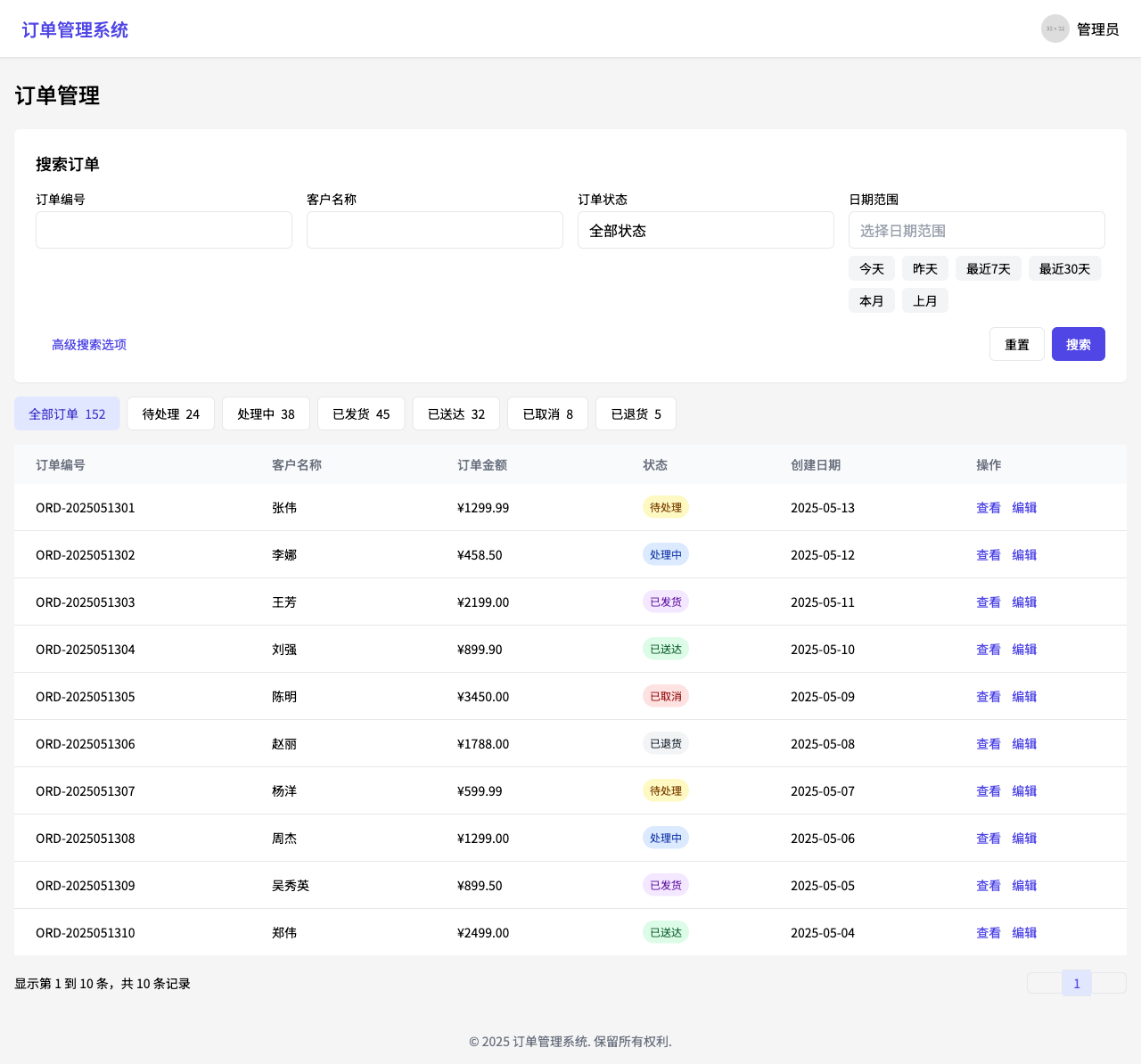

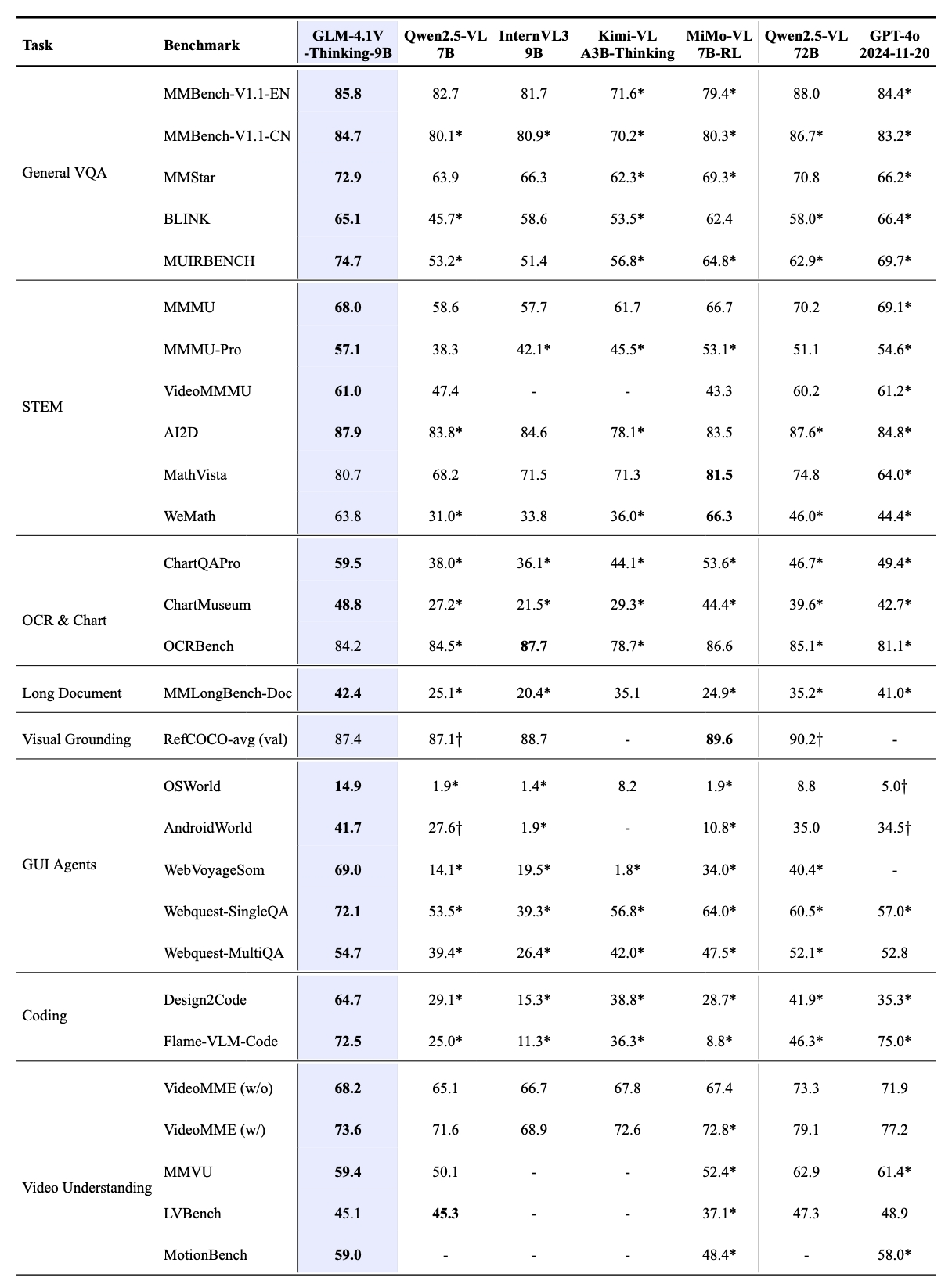

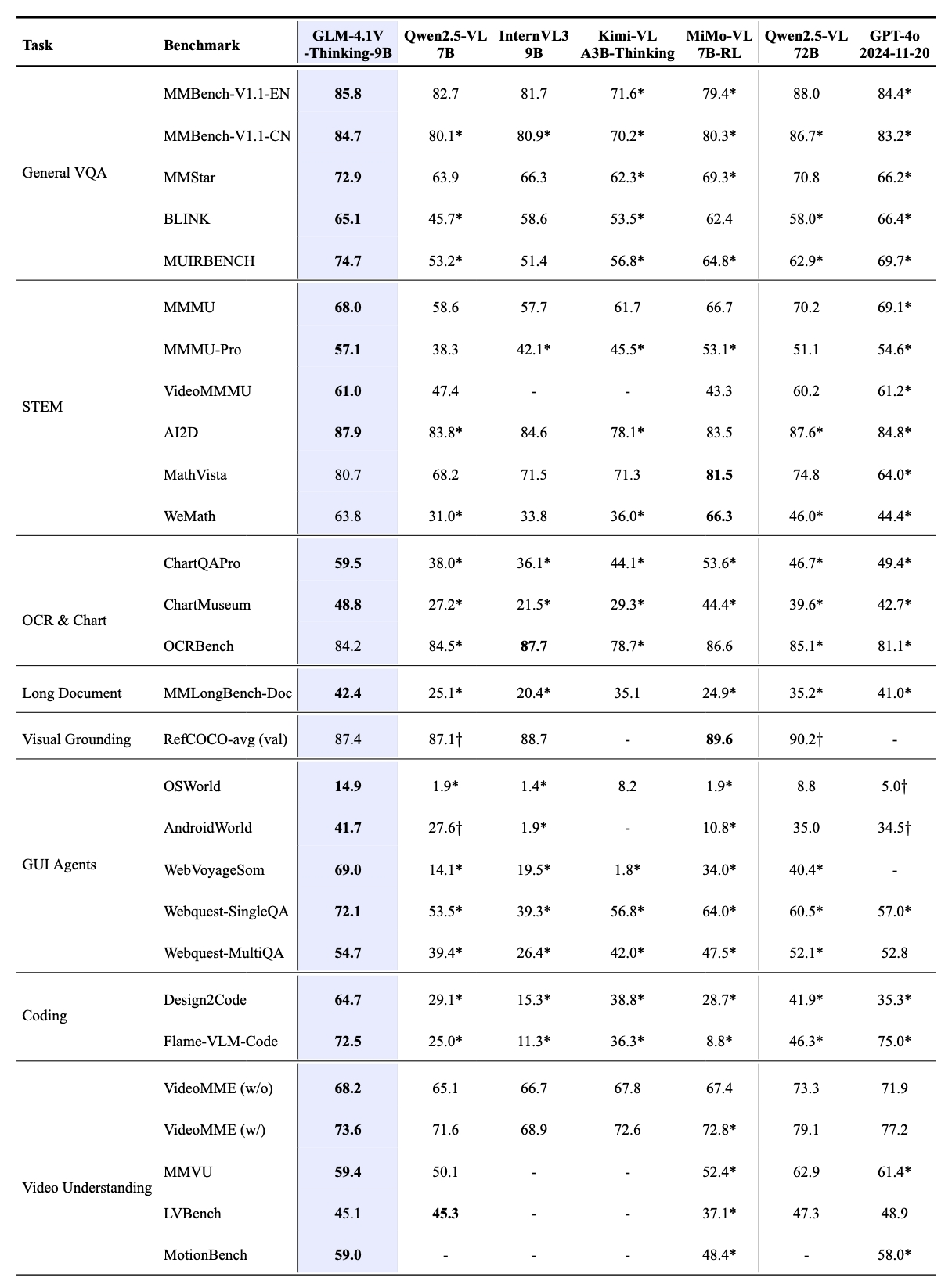

多项视觉语言任务性能 SOTA GLM-4.1V-Thinking 模型在高效部署的同时实现了性能突破。在 MMStar、MMMU-Pro、ChartQAPro、OSWorld 等 28 项权威评测中,以 23 项 10B 级模型优异成绩展现硬核实力,其中 18 项指标更是持平或超越 8 倍参数量的主流 VLM 模型 ,充分印证小体积模型的极限性能潜能。 值得注意的是,模型在推荐场景任务处理中展现出卓越的适配能力,其高度的通用性与稳健性在复杂业务场景中尤为凸显。

强大的推理能力 GLM-4.1V-Thinking 在 GLM-4V 架构基础上引入“思维链推理机制 ”,采用“课程采样强化学习策略”,系统性提升模型跨模态因果推理能力与稳定性补足推理能力后的 GLM-4.1V-Thinking ,在面向科学研究、教育、自主 Agent 及多模态助手等更复杂现实世界应用时,解决问题的能力更加强大。

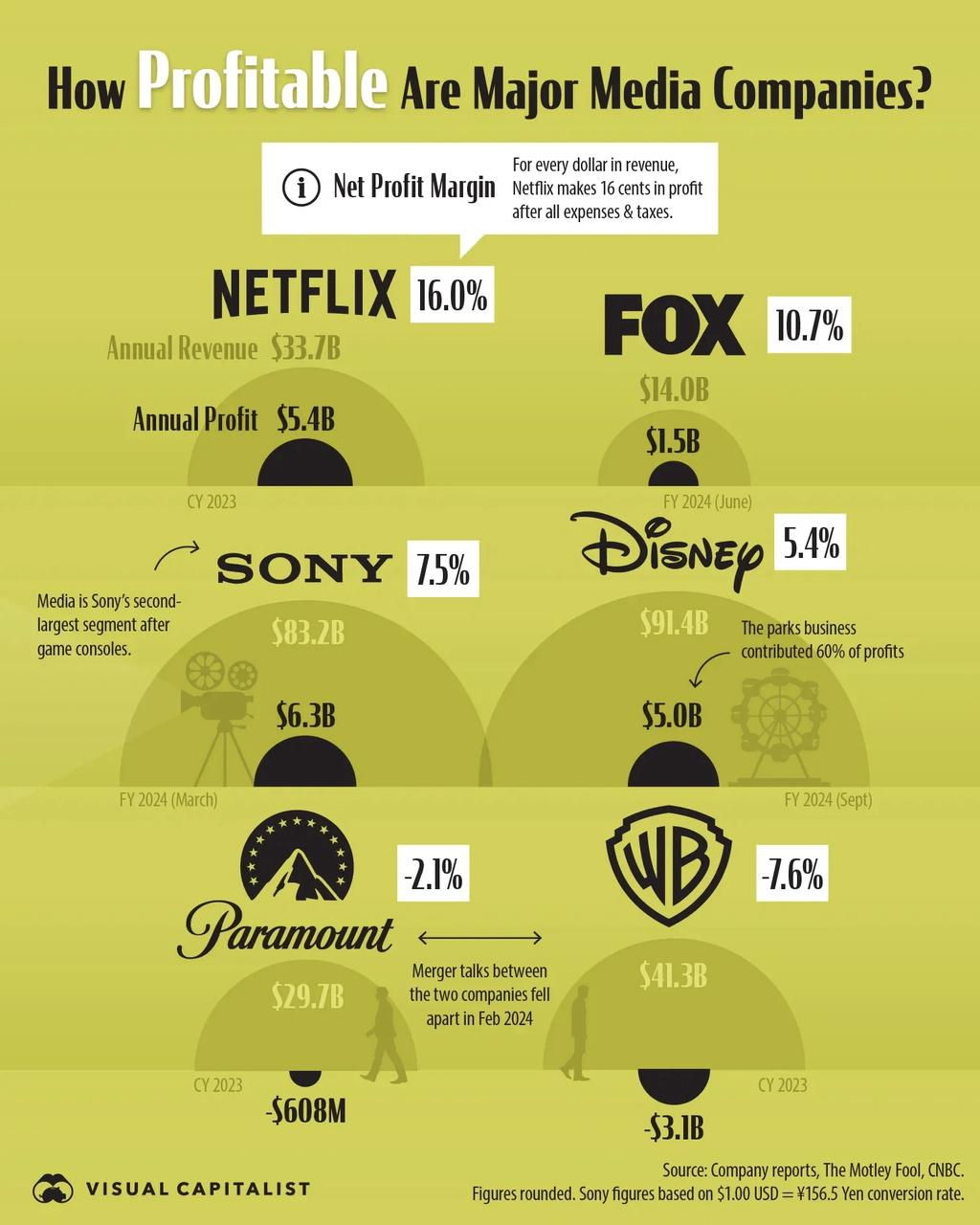

图片问答

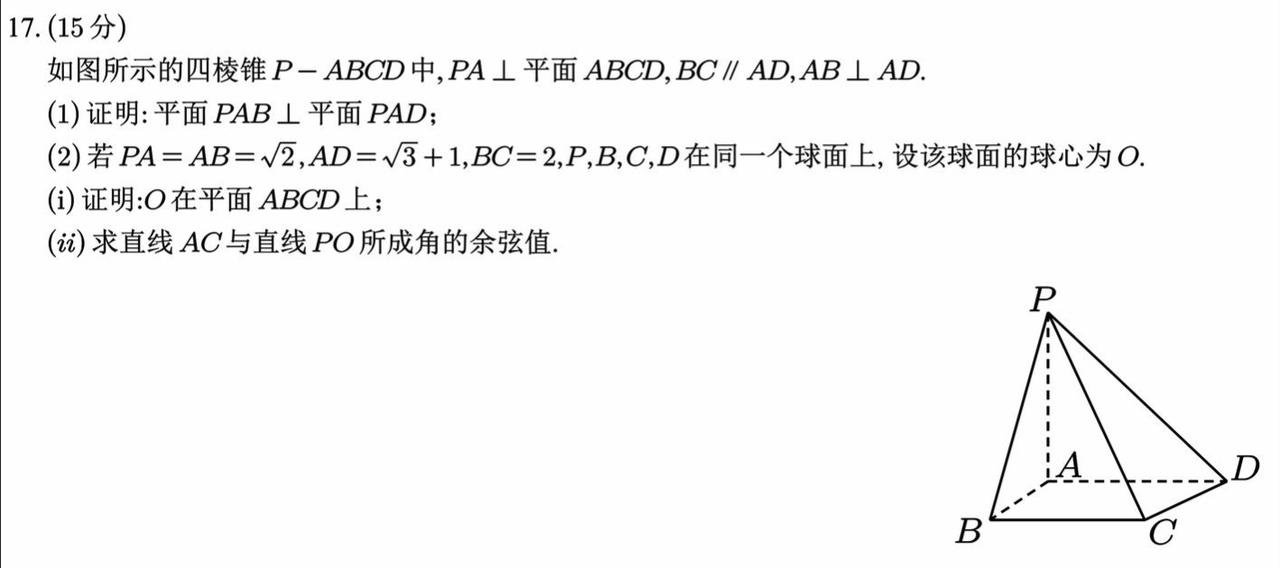

学科解题

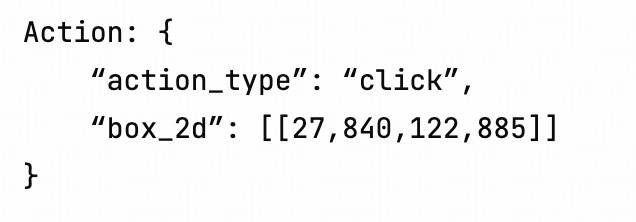

GUI Agent

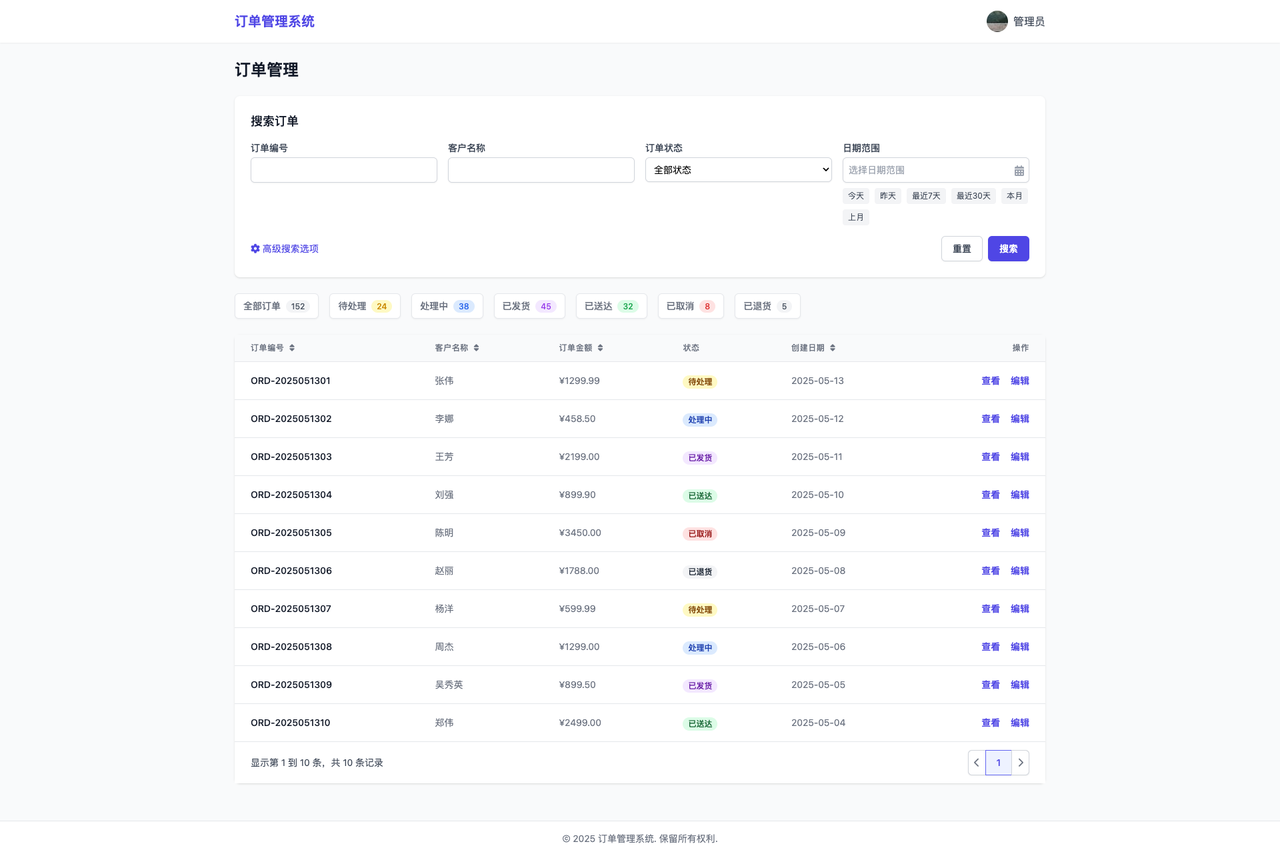

前端网页Coding

输入

输出 Sony has the highest annual profit at $6.3B. For Sony, the note states, “Media is Sony’s second - largest segment after game consoles.” Thus, the largest segment is game consoles.

输入

输出 思考过程略.⊥ 平面 PAD。

输入

输入

输出 生成的React代码后渲染的网页界面截图:

安装 SDK # 安装最新版本 pip install zai-sdk # 或指定版本 pip install zai-sdk== 0.2.0

验证安装 import zai print (zai. __version__ )

调用示例 from zai import ZhipuAiClient client = ZhipuAiClient( api_key = "" ) # 请填写您自己的 APIKey response = client.chat.completions.create( model = "glm-4.1v-thinking-flashx" , # 请填写您要调用的模型名称 messages = [ { "role" : "user" , "content" : [ { "type" : "text" , "text" : "请帮我解决这个题目,给出详细过程和答案" }, { "type" : "image_url" , "image_url" : { "url" : "https://img.iplaysoft.com/wp-content/uploads/2019/free-images/free_stock_photo.jpg" }} ] } ] ) print (response.choices[ 0 ].message.content)

安装 SDK Maven < dependency > < groupId > ai.z.openapi </ groupId > < artifactId > zai-sdk </ artifactId > < version > 0.3.0 </ version > </ dependency >

Gradle (Groovy) implementation 'ai.z.openapi:zai-sdk:0.3.0'

调用示例 import ai.z.openapi.ZhipuAiClient; import ai.z.openapi.service.model. * ; import ai.z.openapi.core.Constants; import java.util.Arrays; public class GLM41VThinkingExample { public static void main ( String [] args ) { String apiKey = "" ; // 请填写您自己的APIKey ZhipuAiClient client = ZhipuAiClient . builder (). ofZHIPU () . apiKey (apiKey) . build (); ChatCompletionCreateParams request = ChatCompletionCreateParams . builder () . model ( "glm-4.1v-thinking-flashx" ) . messages ( Arrays . asList ( ChatMessage . builder () . role ( ChatMessageRole . USER . value ()) . content ( Arrays . asList ( MessageContent . builder () . type ( "text" ) . text ( "描述下这张图片" ) . build (), MessageContent . builder () . type ( "image_url" ) . imageUrl ( ImageUrl . builder () . url ( "https://aigc-files.bigmodel.cn/api/cogview/20250723213827da171a419b9b4906_0.png" ) . build ()) . build ())) . build () )) . build (); ChatCompletionResponse response = client . chat (). createChatCompletion (request); if ( response . isSuccess ()) { Object reply = response . getData (). getChoices (). get ( 0 ). getMessage (). getContent (); System . out . println (reply); } else { System . err . println ( "错误: " + response . getMsg ()); } } }

from zhipuai import ZhipuAI client = ZhipuAI( api_key = "your-api-key" ) # 填写您自己的APIKey response = client.chat.completions.create( model = "glm-4.1v-thinking-flashx" , # 填写需要调用的模型名称 messages = [ { "role" : "user" , "content" : [ { "type" : "text" , "text" : "请帮我解决这个题目,给出详细过程和答案" }, { "type" : "image_url" , "image_url" : { "url" : "传入图片的 url 地址" } } ] } ] ) print (response.choices[ 0 ].message)

请注意,GLM-4.1V-Thinking 模型支持图片和文本的多模态输入,您可以在 messages 中同时包含文本和图片。

API 调用会受到速率限制,当前我们限制的维度是请求并发数量(在途请求任务数量)。不同等级的用户并发保障如下。

模型版本 V0 V1 V2 V3 GLM-4.1V-Thinking-Flash 5 10 15 20 GLM-4.1V-Thinking-FlashX 30 50 80 100

值得注意的是,模型在推荐场景任务处理中展现出卓越的适配能力,其高度的通用性与稳健性在复杂业务场景中尤为凸显。

值得注意的是,模型在推荐场景任务处理中展现出卓越的适配能力,其高度的通用性与稳健性在复杂业务场景中尤为凸显。 值得注意的是,模型在推荐场景任务处理中展现出卓越的适配能力,其高度的通用性与稳健性在复杂业务场景中尤为凸显。

值得注意的是,模型在推荐场景任务处理中展现出卓越的适配能力,其高度的通用性与稳健性在复杂业务场景中尤为凸显。